Mistral AI, la start-up française qui révolutionne l’intelligence artificielle

Mistral AI est fondée en avril 2023 par une équipe de trois chercheurs en intelligence artificielle visionnaires : Arthur Mensch, Guillaume Lample, et Timothee Lacroix ; respectivement Chief Executive Officer, Chief Scientist et Chief Technology Officer au sein de Mistral AI.

Au lancement du projet Mistral AI, le trio de co-fondateurs disposent d’une solide expérience en matière de développement de technologies d’IA : Arthur Mensch a travaillé pour Google DeepMind tandis que Guillaume Lample et Timothee Lacroix ont fait leurs armes chez Meta.

Mistral AI a rapidement fait parler d’elle sur la scène internationale de l’intelligence artificielle. Avec une première levée de fonds de 105 millions d’euros en juin 2023, suivie d’une deuxième levée de fonds de 385 millions d’euros en octobre de la même année, l’entreprise a su convaincre des investisseurs de renom tels que Xavier Niel, le fond d’investissement américain Andreessen Horowitz, des leaders mondiaux de leur industrie comme Salesforce et Nvidia, ainsi que la banque française BNP Paribas. En moins d’un an, la start-up obtient une valorisation estimée à 1,86 milliard d’euros et entre alors dans le club très restreint des « licornes », ces sociétés évaluées à plus d’un milliard de dollars.

Cet événement qui profite d’une couverture médiatique importante confère instantanément un statut particulier à la jeune société et permet aux fondateurs d’afficher leur ambitions tout en se démarquant avec une image reposant une approche open source et des valeurs fortes.

Arthur Mensch, CEO de Mistral AI, dans une interview accordée au magazine Les Echos à l’été 2023 :

« Nous sommes ravis de l’accueil réservé à notre technologie par la communauté de l’IA et par les investisseurs. Notre approche unique de l’IA, combinant des modèles de langage de grande taille avec des architectures de système d’experts, nous permet de proposer des solutions innovantes et performantes pour répondre aux besoins de nos clients.

Nous sommes convaincus que notre technologie peut apporter une valeur ajoutée significative dans de nombreux secteurs d’activité, en particulier dans ceux où la compréhension du langage naturel est essentielle. Nous sommes déjà en discussion avec des entreprises de différents secteurs pour explorer les possibilités de collaboration et d’intégration de notre technologie dans leurs processus métier.

Nous sommes également engagés à développer notre activité de manière éthique et responsable, en veillant à ce que nos modèles d’IA soient transparents, explicables et respectueux des valeurs humaines. Nous sommes convaincus que l’IA peut contribuer à un avenir meilleur pour tous, à condition d’être développée et utilisée de manière responsable. »

Guillaume Lample, Chief Scientist de Mistral AI, interview accordée au magazine Forbes en juin 2023 :

« Nous sommes convaincus que l’avenir de l’intelligence artificielle réside dans les modèles de langage de grande taille, capables de comprendre et de générer du langage naturel de manière fluide et cohérente. Notre objectif est de développer des modèles d’IA qui puissent être utilisés dans un large éventail d’applications, allant de la recherche d’informations à la génération de contenu en passant par la traduction automatique.

Nous avons choisi de rendre notre premier modèle, Mistral 7B, disponible sous licence libre Apache 2.0, car nous sommes convaincus que l’ouverture et la collaboration sont essentielles pour faire progresser l’état de l’art dans le domaine de l’IA. Nous sommes ravis de voir que notre approche a suscité un tel engouement de la part de la communauté et nous sommes impatients de voir comment notre technologie sera utilisée dans le futur. »

Timothée Lacroix, CTO de Mistral AI, interview accordée à TechCrunch en juillet 2023 :

« Nous avons créé Mistral AI pour répondre aux défis de l’IA de demain. Nous pensons que l’IA doit être conçue pour être transparente, explicable et éthique. C’est pourquoi nous avons développé une approche unique d’architecture de système d’experts qui nous permet de combiner les avantages des modèles de langage de grande taille avec ceux des modèles plus petits et spécialisés.

Nous sommes convaincus que notre approche novatrice nous permettra de développer des modèles d’IA plus performants, plus fiables et plus éthiques que ceux qui existent actuellement. Nous sommes ravis de voir que notre technologie a déjà suscité l’intérêt de grands acteurs de l’industrie et nous sommes impatients de poursuivre notre développement dans les mois et les années à venir. »

Les premiers modèles de traitement du langage de Mistral AI

Mistral 7B

Le premier modèle de traitement du langage de Mistral AI, Mistral 7B est basé sur une architecture de réseau de neurones profonds et repose sur 7 milliards de paramètres.

Comme annoncé par Guillaume Lample, le modèle Mistral 7B est disponible sous licence libre Apache 2.0, ce qui signifie

que toute personne ou organisation peut l’utiliser, le modifier et le distribuer librement.

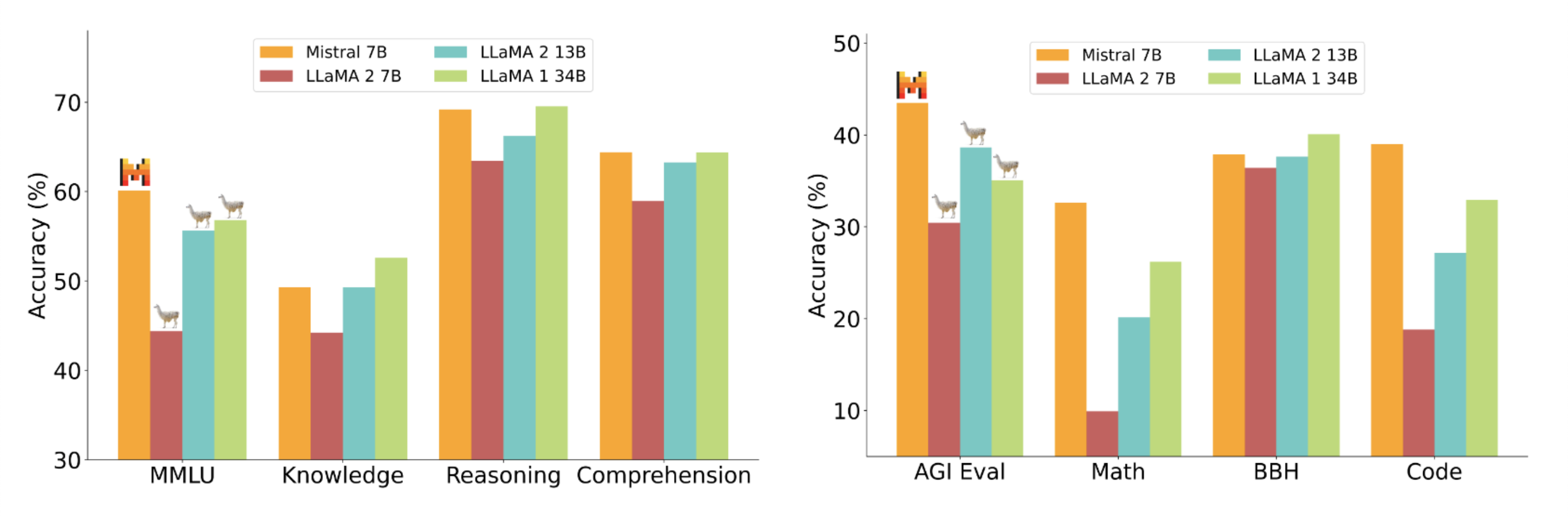

Le modèle Mistral 7B a été salué pour ses performances exceptionnelles et sa capacité à rivaliser avec certains des modèles les plus avancés du moment dans l’industrie.

En particulier, il a été comparé au modèle LLama 2 70B de Meta, alors l’un des modèles de langage les plus performants au monde. Cependant, contrairement à LLama 2 70B, qui repose sur une architecture de transformeur et nécessite une quantité importante de ressources informatiques pour fonctionner, Mistral 7B est basé sur une architecture de réseau de neurones profonds plus légère et plus efficace, ce qui le rend plus accessible et plus facile à utiliser pour les développeurs et les chercheurs.

Mixtral 8x7B

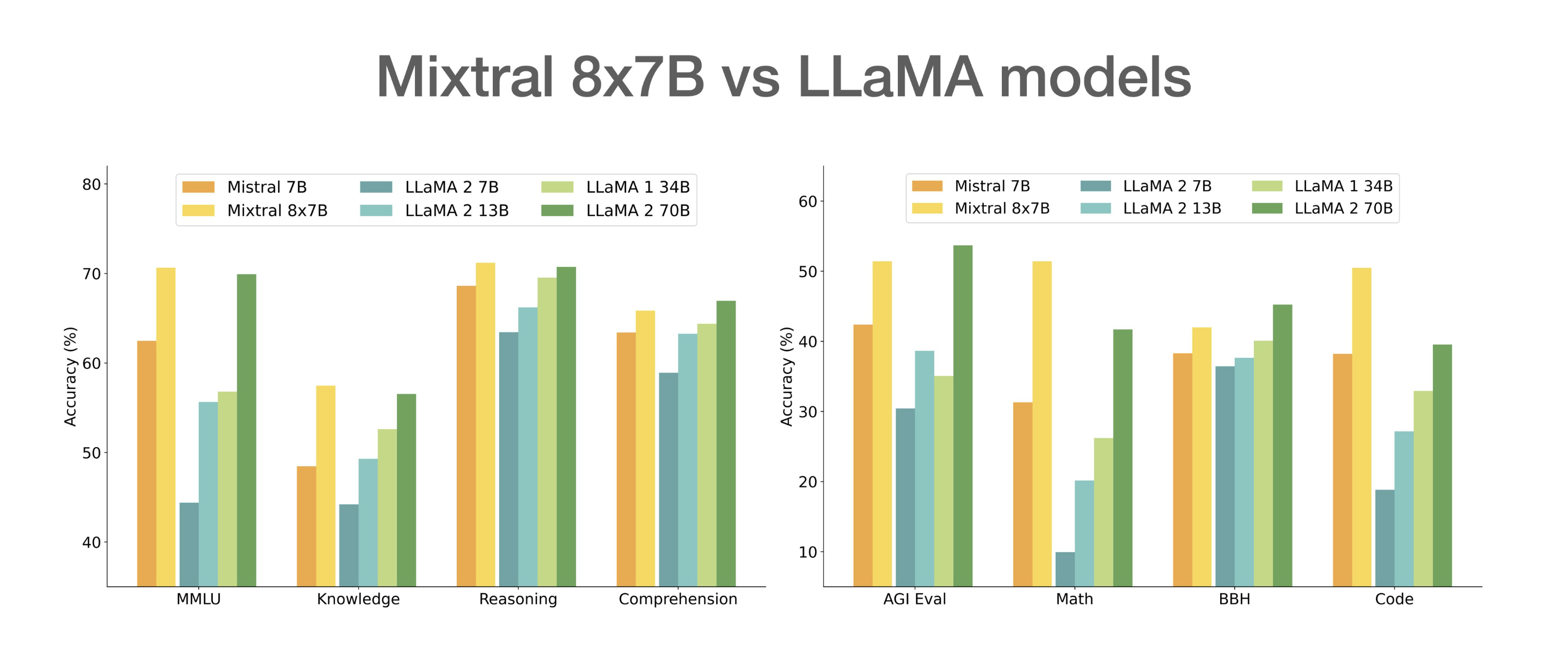

Mixtral 8x7B représente une avancée significative par rapport à son prédécesseur, Mistral 7B, et se positionne là encore comme l’un des modèles les plus performants du marché.

Le modèle Mixtral 8x7B repose sur une architecture novatrice d’architecture du système d’experts, qui permet de combiner les avantages des modèles de langage de grande taille avec ceux des modèles plus petits et spécialisés. Cette approche unique permet à Mixtral 8x7B de bénéficier d’une capacité de compréhension et de génération de langage naturel exceptionnelle, tout en étant plus efficace en termes de ressources informatiques.

Mixtral 8x7B est constitué de 46,7 milliards de paramètres, soit plus de six fois plus que Mistral 7B. Cependant, grâce à son approche d’architecture de système d’experts, il n’utilise que 12,9 milliards de paramètres par token, ce qui le rend plus efficace et plus rapide que les modèles de langage de grande taille traditionnels.

Le modèle Mixtral 8x7B a été entraîné sur un vaste corpus de données textuelles, comprenant des milliards de mots provenant de sources diverses telles que des livres, des articles de presse, des sites web et des réseaux sociaux. Cette formation approfondie lui permet de comprendre un large éventail de concepts et de contextes, ainsi que de générer du texte cohérent et pertinent en réponse à une variété de requêtes. Il est également capable de comprendre et de générer du texte dans cinq langues différentes : français, espagnol, italien, anglais et allemand.

Les tests réalisés par les développeurs de Mistral AI ont montré que Mixtral 8x7B surpasse le modèle LLama 2 70B de Meta, l’un des modèles de langage les plus performants au monde. En particulier, Mixtral 8x7B a obtenu de meilleurs résultats en termes de cohérence et de pertinence du texte généré, ainsi que de compréhension de concepts complexes.

En plus de sa capacité à générer du texte de manière autonome, Mixtral 8x7B peut également être entraîné pour suivre des instructions spécifiques, grâce à la version « Mixtral 8x7B Instruct ». Cette fonctionnalité en fait un outil puissant pour une variété d’applications, telles que la génération de contenu, la traduction automatique, la réponse aux questions, la synthèse de texte et bien plus encore.

Mixtral 8x7B Instruct

Mixtral 8x7B Instruct est une version spécialisée du modèle Mixtral 8x7B développé par Mistral AI.

Cette version a été entraînée pour suivre des instructions spécifiques, ce qui en fait un outil particulièrement utile pour les applications nécessitant une interaction homme-machine précise et contrôlée.

Le modèle Mixtral 8x7B Instruct a été entraîné sur un vaste ensemble de données d’instructions, comprenant des milliers de tâches différentes, allant de la rédaction de courriers électroniques à la planification de rendez-vous en passant par la gestion de projets. Cette formation approfondie lui permet de comprendre et de suivre une grande variété d’instructions, même lorsqu’elles sont formulées de manière complexe ou ambiguë.

L’une des caractéristiques clés du modèle Mixtral 8x7B Instruct est sa capacité à générer des réponses cohérentes et pertinentes en fonction des instructions données. Par exemple, si l’on demande au modèle de planifier un rendez-vous, il sera capable de proposer plusieurs options de dates et d’heures en fonction des disponibilités des différentes parties prenantes, tout en tenant compte des contraintes de temps et de lieu.

Le modèle Mixtral 8x7B Instruct est également capable de comprendre et de suivre des instructions dans plusieurs langues, ce qui en fait un outil particulièrement utile pour les applications multilingues. En outre, il peut être personnalisé pour s’adapter à des besoins spécifiques, en ajoutant des instructions et des exemples supplémentaires à son ensemble de données d’entraînement.

Le modèle Mixtral 8x7B Instruct a été testé dans plusieurs applications réelles, telles que la gestion de projets, la planification de rendez-vous et la rédaction de courriers électroniques. Les résultats ont montré que le modèle était capable de suivre les instructions avec une grande précision et de générer des réponses cohérentes et pertinentes, même dans des contextes complexes.

La plateforme de services de Mistral AI

La plateforme de services destinée aux développeurs de Mistral AI est un outil puissant et innovant qui permet aux développeurs d’accéder directement aux modèles de traitement du langage développés par l’entreprise.

Cette plateforme a été conçue pour faciliter l’intégration des modèles d’IA dans les applications et les services développés par les entreprises et les particuliers.

La plateforme de Mistral AI : un environment créer par des développeurs, pour les développeurs

La plateforme de services de Mistral AI offre une interface de programmation d’application (API RESTful) simple et intuitive qui permet aux développeurs de solliciter les modèles de Mistral AI en temps réel.

Les développeurs peuvent ainsi intégrer facilement les fonctionnalités de traitement du langage naturel de Mistral AI dans leurs propres applications en offrant un accès immédiat à ses modèles de langage au meilleur rapport qualité-prix. Les utilisateurs peuvent facilement sélectionner le modèle qui convient le mieux à leur application et commencer à l’utiliser immédiatement, sans avoir à se soucier des coûts élevés associés à la construction et à la maintenance de leur propre infrastructure d’apprentissage automatique.

La plateforme de services de Mistral AI prend en charge les modèles de traitement du langage développés par l’entreprise, à savoir Mistral 7B et Mixtral 8x7B, Mistral Large, Mistral Next et Mistral Small.

La plateforme de services de Mistral AI offre également une variété d’options de personnalisation pour les développeurs. Les développeurs peuvent personnaliser les paramètres des modèles pour répondre aux besoins spécifiques de leur application et ainsi, améliorer la précision et la pertinence de leurs résultats dans les contextes qui leur sont propre, tels que pour la langue, la longueur du texte, le niveau de détail, etc.

Développer grâce à la plateforme Mistral AI : un outil robuste et agile

La plateforme de services de Mistral AI est conçue pour être évolutive et fiable. Elle peut gérer un grand nombre de requêtes simultanées et offre une disponibilité élevée pour garantir que les applications qui utilisent les modèles de Mistral AI fonctionnent de manière fluide et fiable grâce à une architecture de microservices, ce qui permet aux différents composants de la plateforme de fonctionner indépendamment les uns des autres et de s’adapter automatiquement aux changements de charge de travail. De plus, la plateforme utilise des conteneurs Docker pour garantir que les modèles de langage sont déployés de manière cohérente et sûre dans différents environnements.

La plateforme de services de Mistral AI est actuellement en version bêta et est disponible pour les développeurs sur invitation uniquement. Les développeurs intéressés peuvent s’inscrire sur le site web de Mistral AI pour demander un accès à la plateforme. Ils pourront ainsi accéder aux guides et une communauté active pour aider les utilisateurs à créer leurs applications. Les guides fournissent des instructions détaillées sur la façon d’utiliser les modèles de langage de Mistral AI dans différents cas d’utilisation, tandis que la communauté permet aux utilisateurs de poser des questions et de partager leurs connaissances avec d’autres développeurs.

Sécurité sur la plateforme Mistral AI

La plateforme de Mistral AI est sécurisée et conforme aux normes de l’industrie.

Toutes les données des utilisateurs sont chiffrées en stockage à l’aide d’un chiffrement AES 256 bits, cela signifie que les données sont converties en un code secret à l’aide d’une clé de chiffrement de 256 bits, ce qui les rend illisibles pour quiconque n’a pas la clé de déchiffrement.

Le chiffrement AES 256 bits est considéré comme l’un des standards les plus sécurisés en matière de chiffrement de données et est largement utilisé dans les applications de sécurité informatique pour protéger les données sensibles. De plus, toutes les données en transit sont chiffrées à l’aide de TLS (Transport Layer Security) 1.2 ou supérieur, ce qui garantit que les données sont protégées contre les interceptions et les attaques ou écoutes indésirables pendant leur transfert entre le client et le serveur.

Ces mesures de sécurité sont essentielles pour protéger les données sensibles des utilisateurs et garantir la confidentialité et l’intégrité des données.

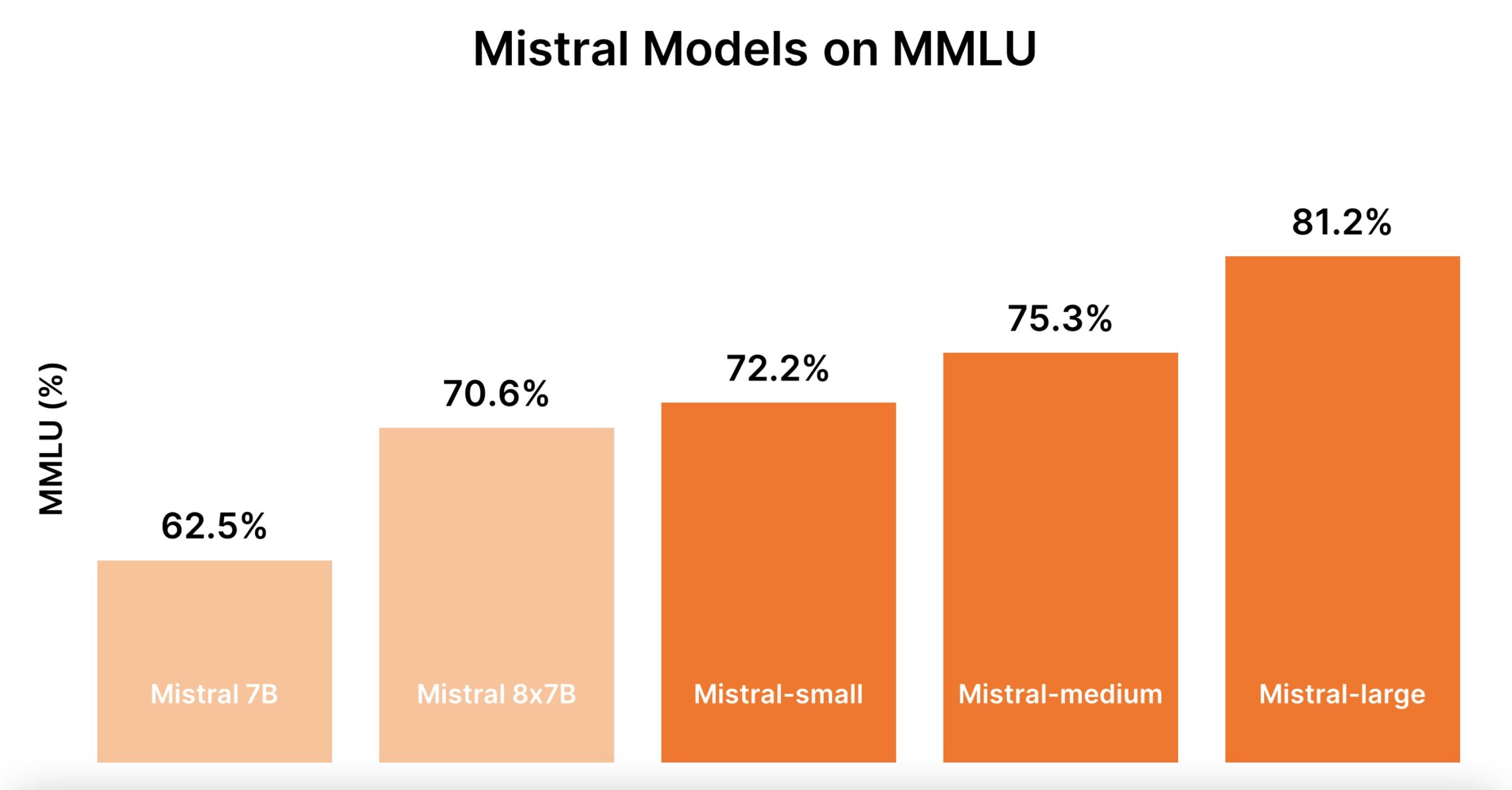

Large, Next et Small : la nouvelle génération de modèles de langage de Mistral AI

Après le succès de ses premiers modèles de langage, Mistral AI a annoncé en février 2024 le lancement de sa deuxième génération de modèles de langage, baptisés « Mistral Large », « Mistral Next » et « Mistral Small ».

Ces nouveaux modèles ont été conçus pour répondre aux besoins croissants des entreprises et des développeurs en matière de traitement automatique du langage naturel (NLP).

Dans cette section, nous allons explorer les caractéristiques et les fonctionnalités de chacun de ces modèles.

Mistral Large

Mistral Large est le modèle de langage le plus avancé de Mistral AI. Il a été conçu pour traiter des tâches complexes de NLP telles que la compréhension de texte, la génération de texte et la traduction automatique. Mistral Large est basé sur l’architecture Transformer et utilise une technique d’apprentissage profond appelée « pre-training » pour apprendre à partir de vastes quantités de données textuelles.

Le modèle a été entraîné sur un corpus de données massif comprenant des milliards de mots provenant de diverses sources, telles que des livres, des articles de presse et des sites web. Cette formation approfondie permet à Mistral Large de comprendre et de générer du texte dans de nombreux domaines différents, avec une précision et une cohérence remarquables.

Mistral Large est également capable de gérer des tâches de NLP multilingues, ce qui en fait un choix idéal pour les entreprises opérant à l’échelle mondiale. Il prend actuellement en charge l’anglais, le français, l’espagnol, l’allemand et le chinois, avec des plans pour ajouter d’autres langues à l’avenir.

Mistral Next

Mistral Next est un modèle de langage spécialement conçu pour les tâches de NLP qui nécessitent une réponse rapide et précise. Il est basé sur l’architecture de réseau neuronal récurrent (RNN) et utilise une technique d’apprentissage profond appelée « fine-tuning » pour s’adapter à des tâches spécifiques.

Le modèle a été entraîné sur un corpus de données plus petit que celui de Mistral Large, mais il a été optimisé pour répondre rapidement aux requêtes des utilisateurs. Mistral Next est idéal pour les applications de chatbot, les assistants vocaux et les systèmes de réponse automatique aux e-mails.

Mistral Next prend en charge plusieurs langues, y compris l’anglais, le français, l’espagnol et l’allemand. Il est également capable de gérer des tâches de NLP plus complexes, telles que la reconnaissance d’entités nommées et l’analyse de sentiment.

Mistral Small

Mistral Small est un modèle de langage léger et efficace, conçu pour les applications de NLP qui nécessitent une faible consommation de ressources. Il est basé sur l’architecture de réseau neuronal convolutif (CNN) et utilise une technique d’apprentissage profond appelée « distillation de connaissances » pour compresser les connaissances apprises par Mistral Large dans un modèle plus petit.

Le modèle a été entraîné sur un corpus de données similaire à celui de Mistral Large, mais il a été optimisé pour fonctionner sur des appareils mobiles et des ordinateurs de bureau avec une faible puissance de traitement.

Mistral Small est idéal pour les applications de traitement de texte, les correcteurs orthographiques et les outils de traduction.

Mistral Small prend en charge plusieurs langues, y compris l’anglais, le français, l’espagnol et l’allemand.

Bien qu’il soit moins puissant que Mistral Large et Mistral Next, il est capable de gérer des tâches de NLP simples telles que l’analyse de sentiment et la classification de texte.

Avec le lancement de sa deuxième génération de modèles de langage, Mistral AI continue d’innover dans le domaine du NLP. Les nouveaux modèles Large, Next et Small offrent une gamme complète de fonctionnalités pour répondre aux besoins croissants des entreprises et des développeurs. Que vous ayez besoin d’un modèle puissant pour gérer des tâches complexes de NLP, d’un modèle rapide et réactif pour les applications de chatbot, ou d’un modèle léger et efficace pour les appareils mobiles, Mistral AI a un modèle adapté à vos besoins.

Déploiement des solutions Mistral AI : choisissez la méthode adaptée à vos besoins

Déployer Mistral AI via le Cloud

Mistral AI propose différentes solutions de déploiement pour ses modèles de langage, permettant ainsi aux entreprises et aux développeurs de choisir celle qui convient le mieux à leurs besoins et à leur infrastructure.

La première solution de déploiement proposée par Mistral AI est le cloud. Les modèles de langage peuvent être déployés sur les principales plateformes cloud, telles qu’Amazon Web Services, Microsoft Azure et Google Cloud Platform. Cette option permet aux entreprises de bénéficier d’une scalabilité et d’une flexibilité accrues, ainsi que d’une réduction des coûts d’infrastructure. Les utilisateurs peuvent accéder aux modèles de langage via des API REST ou des bibliothèques clientes dédiées.

En plus de ces solutions de déploiement, Mistral AI propose également une plateforme de services destinée aux développeurs pour leur permettre de solliciter directement les modèles de langage. Cette plateforme offre une interface utilisateur

graphique conviviale, permettant aux développeurs de tester et d’évaluer les modèles de langage, ainsi que de créer des applications personnalisées à l’aide des API et des bibliothèques clientes proposées par Mistral AI.

Mistral AI propose donc une gamme complète de solutions de déploiement pour ses modèles de langage, permettant aux entreprises et aux développeurs de choisir celle qui convient le mieux à leurs besoins et à leur infrastructure. Qu’il s’agisse du cloud, du déploiement sur site ou d’une solution hybride, Mistral AI offre une flexibilité et une scalabilité accrues pour répondre aux besoins des entreprises en matière de traitement du langage naturel.

Déployer son modèle Mistral AI sur site

La deuxième solution de déploiement proposée par Mistral AI est le déploiement sur site. Cette option permet aux entreprises de déployer les modèles de langage sur leur propre infrastructure, ce qui peut être particulièrement utile pour les applications nécessitant une sécurité et une confidentialité accrues. Mistral AI propose des conteneurs Docker préconfigurés pour faciliter le déploiement sur site. Les utilisateurs peuvent également personnaliser les modèles de langage en fonction de leurs besoins spécifiques.

Comment déployer son modèle Mistral AI de manière hybride ?

Mistral AI propose une solution de déploiement hybride, combinant les avantages du cloud et du déploiement sur site. Cette option permet aux entreprises de déployer les modèles de langage sur leur propre infrastructure, tout en bénéficiant de la scalabilité et de la flexibilité du cloud. Les utilisateurs peuvent également choisir de déployer certains modèles de langage dans le cloud et d’autres sur site, en fonction de leurs besoins spécifiques.

Mistral AI propose donc une gamme complète de solutions de déploiement pour ses modèles de langage, permettant aux entreprises et aux développeurs de choisir celle qui convient le mieux à leurs besoins et à leur infrastructure. Qu’il s’agisse du cloud, du déploiement sur site ou d’une solution hybride, Mistral AI offre une flexibilité et une scalabilité accrues pour répondre aux besoins des entreprises en matière de traitement du langage naturel.

Le partenariat de Mistral AI et Microsoft pour développer des modèles d’IA toujours plus performants

Le 26 février 2024, Mistral AI a annoncé un partenariat stratégique avec Microsoft.

Cette collaboration vise à intégrer le modèle Mistral Large au sein du cloud Azure, élargissant ainsi considérablement l’accès à ce modèle d’IA de pointe.

Grâce à ce partenariat, les utilisateurs d’Azure pourront bénéficier des capacités avancées de Mistral Large en matière de traitement du langage naturel, telles que la compréhension de texte, la génération de langage, la traduction automatique et l’analyse de sentiment.

Les développeurs pourront également utiliser les API de Mistral Large pour intégrer ces fonctionnalités dans leurs propres applications et services.

Le choix de Microsoft comme partenaire stratégique s’explique par la position de leader de l’entreprise dans le domaine du cloud computing et de l’intelligence artificielle. En intégrant Mistral Large à Azure, Microsoft renforce son offre de services d’IA et offre à ses clients une solution complète pour répondre à leurs besoins en matière de traitement du langage naturel.

De son côté, Mistral AI bénéficiera de l’expertise de Microsoft en matière de cloud computing et de sa présence mondiale pour étendre sa portée et toucher de nouveaux marchés.

Ce partenariat permettra également à Mistral AI de bénéficier des ressources et des investissements de Microsoft pour poursuivre son développement et son innovation dans le domaine de l’IA.

Ce partenariat est scellé par une participation minoritaire de Microsoft au capital Mistral AI moyennant un investissement de 15 millions d’euros, un mouvement qui souligne la confiance et l’investissement des géants technologiques dans le potentiel et l’avenir de Mistral AI.

Le partenariat entre Mistral AI et Microsoft est une étape majeure dans le développement de l’entreprise française et renforce sa position sur le marché de l’IA.

En intégrant Mistral Large à Azure, les deux entreprises offrent une solution complète et performante pour répondre aux besoins croissants en matière de traitement du langage naturel.